URL Parameters یا همان پارامترهای URL بخشی جداییناپذیر از ساختارهای URL هستند. هرچند این پارامترها، ابزارهای ارزشمندی برای متخصصان سئو به شمار میروند، اما اغلب چالشهای جدی برای رتبهبندی وبسایت شما به وجود میآورند.

در این مطلب، عمومیترین مسائل مربوط به سئو را که هنگام کار با URL Parameters با آنها مواجه خواهید شد را بررسی میکنیم.

در این مقاله با مطالب زیر آشنا میشوید:

ToggleURL Parameters چیست؟

URL Parameters (که از آنها به عنوان «رشتههای query» و «پارامترهای URL query» نیز نام برده میشود) عناصری هستند که در URLهای شما درج میشوند تا در فیلتر کردن و سازماندهی محتوا یا ردیابی اطلاعات در وبسایتتان، به شما کمک کنند.

به طور خلاصه، پارامترهای URL راهی برای انتقال اطلاعات مربوط به یک کلیک با استفاده از خود URL است. در واقع این پارامترها به شما خواهد گفت که کلیکهای دریافتی شما از چه کانالهایی بوده است: شبکههای اجتماعی، تبلیغات بنری و…؟

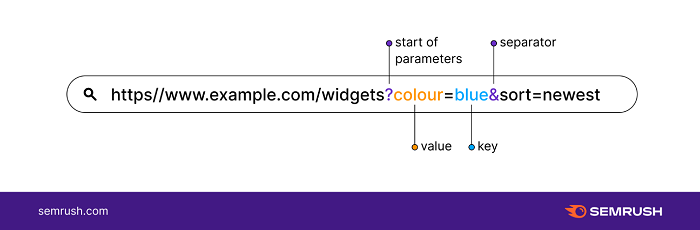

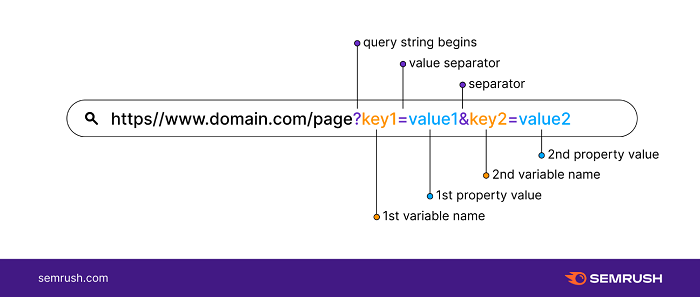

برای شناسایی پارامترهای URL، به بخشی از URL که بعد از علامت سوال میآید (؟) مراجعه کنید. URL Parameters از یک کلید و یک مقدار ساخته میشوند که با علامت مساوی (=) از یکدیگر جدا شده و چندین پارامتر نیز هر کدام توسط یک ampersand (&) از هم جدا میشوند.

یک رشته URL با Parameters به این شکل است:

https//www.domain.com/page?key1=value1&key2=value2:

- Key1: نام متغیر اول

- Key2: نام متغیر دوم

- VALUE1: اولین مقدار ویژگی

- VALUE2: دومین مقدار ویژگی

- ?: رشته Query شروع میشود

- =: جداکننده مقدار (value separator)

- &: جداکننده پارامترها

چطور از URL Parameters استفاده کنیم؟ (با ذکر مثال)

پارامترهای URL معمولا برای مرتبسازی محتوا در یک صفحه مورد استفاده قرار میگیرند و این امر باعث میشود کاربران بتوانند محصولات موجود در فروشگاه آنلاین را به راحتی بررسی کنند. این رشتههای Query به کاربران امکان میدهد یک صفحه را طبق فیلترهای خاص پیدا کرده و فقط مقدار مشخصی از موارد را در هر صفحه مشاهده کنند.

رشتههای Query از پارامترهای ردیابی رایج هستند. دیجیتال مارکترها معمولا برای نظارت بر میزان مراجعه به سایت، از آنها استفاده میکنند و از این طریق مشخص میشود که آیا کمپینها و تبلیغاتشان در شبکههای اجتماعی، رسانهها و… موفقیتآمیز بوده یا خیر.

URL Parameters چگونه کار میکنند؟

طبق گفته توسعهدهندگان گوگل، پارامترهای URL دو نوع دارند:

۱- پارامترهای تغییر دهنده محتوا یا Content-modifying parameters (فعال): پارامترهایی که محتوای نمایش داده شده در صفحه را تغییر میدهند.

به عنوان مثال برای ارسال مستقیم کاربر به یک محصول خاص به نام ‘xyz’ از URL زیر استفاده میکنیم:

http://domain.com?productid=xyz

۲- پارامترهای ردیابی (غیرفعال) برای ردیابی پیشرفته یا Tracking parameters: پارامترهایی که اطلاعات مربوط به کلیک را منتقل میکنند – یعنی از کدام شبکه ایجاد شده، مربوط به کدام کمپین یا گروه تبلیغاتی است و… – اما محتوای صفحه را تغییر نمیدهند.

این اطلاعات بهطور واضح در یک الگوی ردیابی ثبت میشوند و شامل دادههای ارزشمندی هستند که به شما کمک میکنند تا فعالیتهای بازاریابی خود را بررسی کنید.

به عنوان مثال برای بررسی میزان بازدید از خبرنامه سایت خود میتوانید از URL زیر استفاده کنید:

https://www.domain.com/https://www.domain.com/?utm_source=newsletter&utm_medium=email

یا مثلا برای جمعآوری دادههای یک کمپین با URLهای سفارشی میتوان پارامترهای زیر را به کار برد:

https://www.domain.com/?utm_source=twitter&utm_medium=tweet&utm_campaign=summer-sale

شاید استفاده از پارامترها نسبتا ساده به نظر برسد، اما یک روش صحیح و نادرست برای استفاده از آنها وجود دارد که در ادامه، راجع به آن صحبت خواهیم کرد.

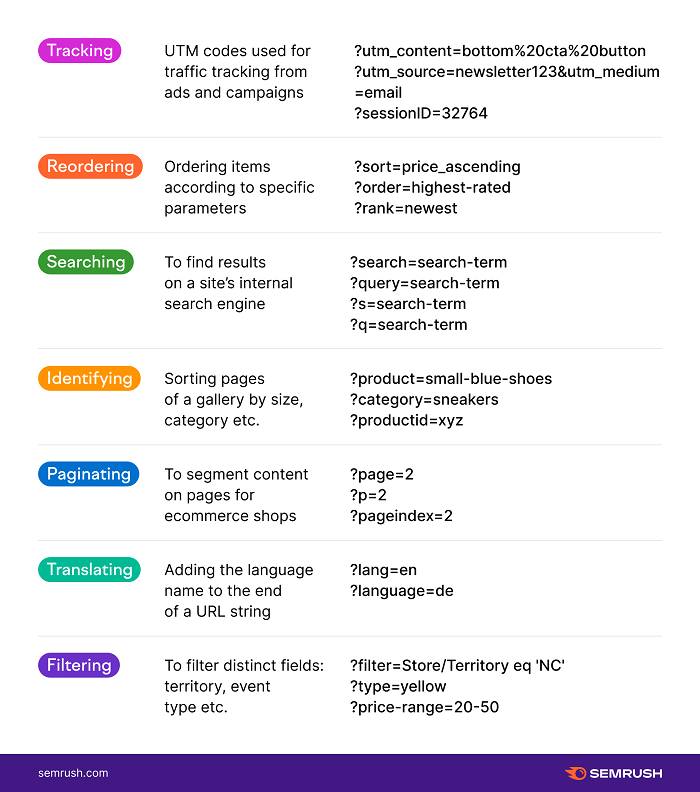

مثالهایی از URL Parameters

موارد معمول استفاده از پارامترهای URL عبارتاند از:

چه زمانی URL Parameters در سئو مشکل ایجاد میکند؟

اغلب توصیههای سازگار با سئو برای ساختار URL، نشان میدهد که نباید تا جایی که ممکن است از پارامترهای URL استفاده کنید. دلیل این امر این است که، گرچه پارامترهای URL مفید هستند، اما چون مقدار زیادی از کرال باجت شما را مصرف میکنند، سرعت خزندههای وب را کاهش میدهند.

URL Parameters منفعل با ساختار ضعیف که محتوای صفحه را تغییر نمیدهند (مانند session IDها، کدهای UTM و شناسههای وابسته) امکان ایجاد URLهای بیپایان با محتوای غیرخاص را دارند.

رایجترین مشکلات مربوط به سئو ناشی از URL Parametersعبارتاند از:

۱- محتوای تکراری: از آنجا که هر نشانی اینترنتی توسط موتورهای جستجو به عنوان یک صفحه مستقل در نظر گرفته میشود، ممکن است چندین نسخه از همان صفحه ایجاد شده توسط یک URL Parameter به عنوان محتوای تکراری در نظر گرفته شود. دلیل این امر، این است که صفحهای که مطابق پارامتر URL تنظیم میشود، اغلب بسیار شبیه به صفحه اصلی است، در حالی که برخی از پارامترها ممکن است دقیقا همان محتوای اصلی را بازگردانند.

۲- از دست دادن کرال باجت یا بودجه خزش: حفظ ساختار URL ساده بخشی از اصول بهینهسازی URL است. URLهای پیچیده با چندین پارامتر، URLهای مختلفی را ایجاد خواهند کرد که به محتوای یکسان (یا مشابه) اشاره میکنند. به گفته توسعهدهندگان گوگل، کرالرها ممکن است تصمیم بگیرند که از هدر رفتن پهنای باند برای ایندکس کردن تمام محتوای وبسایت جلوگیری کنند و آن را به عنوان یک صفحه بیارزش و بیکیفیت علامتگذاری کرده و به صفحه بعدی بروند.

۳- همنوع خواری کلمات کلیدی یا Keyword cannibalization: نسخههای فیلتر شده URL اصلی، همان گروه کلمات کلیدی را هدف قرار میدهند. این امر منجر به رقابت صفحات مختلف برای رتبهبندی یکسان میشود، که ممکن است باعث شود کرالرها به این نتیجه برسند که صفحات فیلتر شده فایدهای برای کاربران ندارند و هیچ ارزشی به آنها اضافه نمیکنند.

۴- سیگنالهای رتبهبندی تضعیف شده: وقتی چندین URL که به یک محتوا اشاره دارند، لینکهای و اشتراکهای اجتماعی ممکن است به هر نسخه پارامتری از صفحه اشاره کنند. این میتواند کرالرها را سردرگم کند، زیرا آنها نمی فهمد کدام یک از صفحات رقیب را باید برای درخواست جستجو، رتبهبندی کند.

۵- خوانایی ضعیف URL: هنگام بهینهسازی ساختار URL، ما ترجیح میدهیم URL ساده و قابل فهم باشد. رشتهای طولانی از کد و اعداد، هیچوقت نمیتواند این سادگی را ایجاد کند. یک URL پارامتردار برای کاربران عملا قابل خواندن نیست. وقتی URLهای پارامتردار در SERPها، در یک خبرنامه یا در شبکههای اجتماعی نمایش داده میشوند، اسپم و غیرقابل اعتماد به نظر میرسند و باعث میشوند کاربران نتوانند روی صفحه کلیک کرده و آنها را به اشتراک بگذارند.

نحوه مدیریت URL Parameters برای داشتن یک سئوی خوب

اکثر مشکلات سئویی که در بالا معرفی کردیم، به یک دلیل اصلی اشاره دارند: کرالینگ و ایندکس شدن کلیه URLهای پارامتر شده. اما خوشبختانه، وبمستران در برابر ایجاد بیپایان URL جدید از طریق Parameters ناتوان نیستند.

برای داشتن یک URL Parameters خوب، ما تگگذاری مناسب را پیدا میکنیم.

توجه داشته باشید: هنگامی که URLهای حاوی پارامترها محتوای تکراری و غیر منحصر به فردی را نمایش میدهند، (یعنی آنهایی که توسط پارامترهای غیرفعال URL تولید میشوند) مشکلات مختلفی برای سئو به وجود میآید. این لینکها – و فقط همین لینکها- نباید ایندکس شوند.

کرال باجت خود را بررسی کنید

کرال باجت شما، تعداد صفحاتی است که رباتها قبل از رفتن به صفحات دیگر، در سایت شما کرال میکنند. کرال باجت هر وبسایت متفاوت است و همیشه باید اطمینان حاصل کنید که این بودجه را هدر نمیدهید.

متأسفانه، داشتن URLهای قابل کرال شدن و کم ارزش باعث اتلاف کرال باجت شما میشود.

لینکهای داخلی پیوسته

اگر وبسایت شما دارای URLهای پارامتردار زیادی باشد، مهم است که به کرالرها سیگنال دهید که کدام صفحات را ایندکس نکنند و پیوسته به صفحه ثابت و غیر پارامتری لینک بدهند.

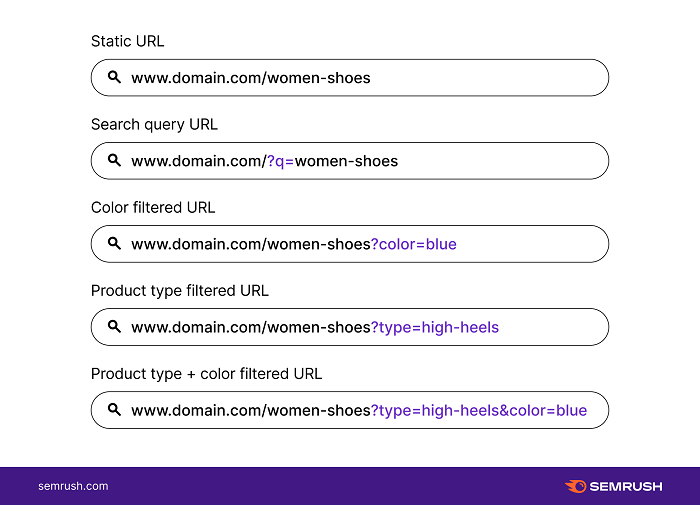

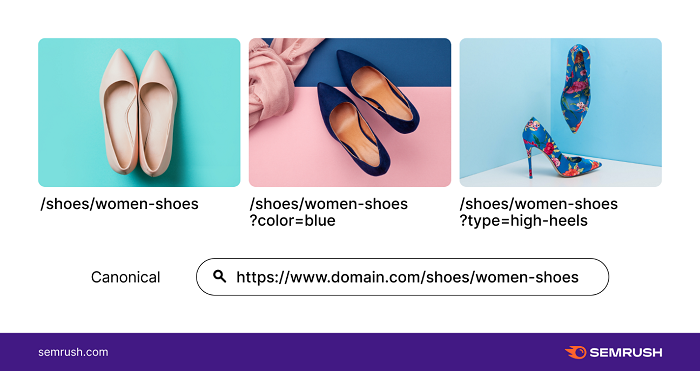

به عنوان مثال، در اینجا چند URL پارامتر شده از یک فروشگاه آنلاین کفش آورده شده است:

در این حالت، مراقب باشید و همواره فقط به صفحات استاتیک لینک داده و هرگز به نسخههای دارای پارامتر لینک ندهید. به این ترتیب از ارسال سیگنالهای متناقض به موتورهای جستجو در مورد ایندکس صفحات جلوگیری خواهید کرد.

یک نسخه از URL را کنونیکال کنید

هنگامی که تصمیم گرفتید کدام صفحه استاتیک باید ایندکس شود، به یاد داشته باشید که آن را کنونیکال کنید. با ارجاع به URL دلخواه، تگهای کنونیکال را در URLهای پارامتر شده قرار دهید.

اگر پارامترهایی را برای کمک به پیمایش کاربران در صفحه لندینگ فروشگاه آنلاین کفش ایجاد کنید، همه تغییرات URL باید شامل تگ کنونیکال باشد که صفحه اصلی لندینگ را به عنوان صفحه متعارف، مشخص میکند. به عنوان مثال:

- /shoes/women-shoes/

- /shoes/women-shoes?color=blue

- /shoes/women-shoes?type=high-heels

در این حالت، سه URL بالا «مرتبط» با صفحه لندینگ کفش زنانه غیرپارامتر شده هستند. با این کار به کرالرها سیگنالی ارسال میشود که فقط صفحه اصلی لندینگ باید ایندکس شود و نه URLهای پارامتر شده.

کرالرها را با استفاده از Disallow مسدود کنید

URL Parameters برای مرتبسازی و فیلتر کردن میتوانند بهطور بالقوه URLهای بیپایان با محتوای غیر منحصر به فرد ایجاد کنند. میتوانید با استفاده از تگ Disallow، دسترسی کرالرها را به این بخشهای وبسایتتان منع کنید.

مسدود کردن کرالرها، مانند Googlebot، برای کرال شدن محتوای تکراری پارامتر شده، به معنای کنترل مواردی است که آنها میتوانند از طریق robots.txt به وبسایت شما دسترسی داشته باشند. فایل robots.txt قبل از جستجوی وبسایت توسط رباتها بررسی میشود، بنابراین حواستان باشد URLهای پارامترشده سایتتان را حتما بهینه کنید.

فایل robots.txt زیر هرگونه URL دارای یک علامت سوال را مجاز نمیداند:

*=Disallow:/*?tag

با استفاده از این تگ Disallow، تمام پارامترهای URL برای کرال شدن توسط موتورهای جستجو، مسدود خواهند شد. قبل از انتخاب این گزینه، اطمینان حاصل کنید که هیچ بخش دیگری از ساختار URL شما از پارامترها استفاده نمیکند، در غیر این صورت، آنها نیز مسدود خواهند شد.

برای یافتن آدرسهای اینترنتی حاوی علامت سوال (?) ممکن است نیاز باشد خودتان به صورت دستی وبسایتتان را کرال کنید.

URL Parameters را به URLهای استاتیک منتقل کنید

این بخش به بحث گستردهتری درباره URLهای داینامیک و استاتیک میرسد. بازنویسی صفحات داینامیک به استاتیک، باعث بهبود ساختار URL وبسایت میشود.

با این حال، به خصوص اگر URLهای پارامتر شده در حال حاضر ایندکس شوند، باید نه تنها برای بازنویسی URLها، بلکه برای ریدایرکت آن صفحات به مکانهای استاتیک متناظر با آنها زمان زیادی صرف کنید.

توسعه دهندگان گوگل پیشنهاد میکنند:

- پارامترهای غیرضروری را حذف کرده، اما یک dynamic-looking URL را نگه دارید.

- محتوای استاتیکی ایجاد کنید که با محتوای اصلی داینامیک معادل باشد.

- بازنویسیهای داینامیک / استاتیک را به مواردی محدود کنید که به شما کمک میکنند تا پارامترهای غیرضروری را حذف کنید.

گنجاندن URL Parameters در استراتژی سئو

URL Parameters، اصلاح یا ردیابی محتوا را آسان میکنند. بنابراین ارزش دارد که در صورت لزوم آنها را در سایت خود قرار دهید. شما باید به کرالرهای وب اطلاع دهید که چه زمانهایی URLهای خاص را با پارامترها ایندکس نکنند و نسخهای از صفحه را که دارای بیشترین ارزش و اعتبار است را برجسته کنید.

وقت بگذارید و تصمیم بگیرید که کدام URL Parameters در سایتتان نباید ایندکس شوند. با گذشت زمان، کرالرهای وب بهتر میفهمند که چگونه صفحات سایت شما را کرال کرده و صفحاتش را ارزشگذاری کنند.

واقعا اگه بخواین تمام نکته های یو ار ال رو توضیح بدید باید حداقل ۵ تاوبلاگ رو بهش اختصاص بدید

مرسی از راهنمایی و مقاله کاملی بود

خوشحالیم که براتون مفید بوده.

مثل همیشه عالی ممنون از محتوای بسیار مفیدتون

خوب بود و موفق باشیدو خسته نباشید و جالب بود

متشکریم.

مقاله خوبی بود ، یک سوال داشتم سایتی که دارم از همه لحاظ خوبه اما متاسفانه بعضی مقاله ها جابجایی زیادی در رتبه بندی دارند و بعضا هم از نتایج جستجو به طور موقت حذف می شوند . می تونید راهنمایی بفرمائید ؟

سلام منصور عزیز

موردی که مطرح کردی باید با دقت بیشتری و با داشتن دسترسیهای لازم بررسی بشه. به همین خاطر نمیشه نسخه یکسان و واحدی براش در نظر گرفت.

پیشنهاد میکنم مقاله زیر رو مطالعه کنی و اگر همچنان مشکلت برطرف نشد با ما تماس بگیری تا انشالله بتونیم بهتر کمکت کنیم.

https://www.link-assistant.com/news/reasons-your-rankings-dropped.html

با سلام و خسته نباشید , ممنون از مقاله کاربردی تون یک سوالی از خدمت شما داشتم قالب سایت من یک سری کوئری پارامتر با # می سازه و حالا من می خوام کلیه url هایی که دارای # هستند رو از طریق فایل robots.txt از کراول شدنشون جلوگیری کنم . من این دستور رو ( Disallow: /*#* ) داخل فایل robots قرار دادم , میخواستم بدونم با این دستور ایا همه ی url های دارای # کراول نمی شوند.میشه در این مورد راهنماییم کنید.

سلام مصطفی جان وقتت به خیر

متاسفانه به خوبی متوجه منظورتون نشدم، لطف میکنی یه نمونه رو برامون ارسال کنی که بهتر بتونیم کمکت کنیم؟

خانم شاکری تشکر از وقتی که برای پاسخ به سوال من گذاشتید. من یک سایت فروشگاهی , فروش لپ تاپ و موبایل دارم . داخل صفحه محصولات سایت من سه تا تب وجود داره اولی تب نقد و بررسی و دومی تب مشخصات و سومی تب نظر دهی که وقتی روی هر کدوم کلیک میکنم چند کلمه به url من اضافه میشه.مثلا اگر ادرس یک محصول من این باشه:http://domin name/samsung A12 وقتی روی تب نظر دهی کلیک میکنم تا کامنت بزارم url رو به

http:// domin name/samsung A12/#/tab-comments/&page=1&order=newest_comment تبدیل میکنه . برای هر کدوم از تب ها یک چند کلمه بخوصوص اضافه میکنه حالا با توجه به توضیحاتی که شما زحمت کشیدید و در بالا نوشتید باید این url ها رو disallow کرد درسته ؟

نکته این url هایی که این تب ها به ادرس صفحه محصول سایت من اضافه میکنند اینه که همه شون , داخلشون /#/ دارن برای همین توی کامت قبلی من این دستور Disallow: /*#* رو از شما سوال کردم , که ایا قرار دادن این دستور برای اینکه این url ها توسط روبات های گوگل کرال نشدن درسته ممکنه راهنماییم کنید.

خواهش میکنم مصطفی جان

ممنونم از توضیحات جامع و دقیقتون

این مورد رو بررسی کردیم و بله کاملا درست هست کاری که انجام دادید.

برای اطمینان بیشتر میتونید از طریق لینک زیر خودتون هم بررسی کنید:

https://www.google.com/webmasters/tools/robots-testing-tool

در ضمن اگر کنونیکال آدرسی که ایجاد میشه، آدرس ما قبل # باشه نیازی به بستن این آدرسها با robots.txt ندارید.

سلام با صفحات پارامتردار که در گوگل ایندکس شده اند چکار کنیم؟ فروشگاه نوایندکس کردم اما همچنان صفحات پارامتردار مرتبط با فروشگاه در نتایج گوگل هست؟ ریموال کنم؟

سلام. میتونید با نوایندکس کردن این صفحات اونا رو از لیست صفحات ایندکس شده خارج کنید. نیازی به ریموال نیست، به مرور از ایندکس خارج خواهند شد.

درود بر شما.

من یه سایت فروشگاهی دارم که در آن محصولات متغیر زیادی دارم.یه مدته که در سرچ کنسول در بخش Alternate page with proper canonical tag گوگل صفحات زیادی را کرال می کنه و به این بخش اضافه می کنه. همه این صفحات به صورت url پارامتر هستند،مانند صفحات زیر:

example/product/xyz/?v=145er21

یا

example/product-tag/menshoes/?orderby=price

آیا کرال کردن این صفحات موجب به هدر رفتن بودجه خزش سایت می شود؟ آیا این صفحات پارامتر که مثلا با فیلتر ایجاد می شوند موجب ایجاد محتوای تکراری می شود؟

راهکار جلوگیری از خزش رباتها در این url پارامترها چیست؟ اگر جواب، این کدی است که باید در ربوتکست قرار بدهیم،چرا هیچ سایتی از این کد در ربوتکست خود استفاده نمی کند؟

سلام جناب سالک

بله خزش این صفحات میتونه موجب اتلاف بودجه خزش و ایجاد محتوای تکراری در سایت بشه.

راهکارهایی که برای این موضوع وجود داره اینکه؛

۱- این آدرسها نوایندکس بشن

۲- این آدرسها به آدرس ماقبل خودشون کنونیکال بشن؛

مثلا کنونیکال آدرس example/product/xyz/?v=145er21 میشه این آدرس example/product/xyz/

3- جلوی خزش این آدرسها از طریق فایل robots.txt گرفته بشه (دلیل اینکه شما نمونهی این رو تو سایتهای دیگه پیدا نکردید میتونه این باشه که ساختار urlهای آنها متفاوت از ساختار urlهای سایت شما ست یا اینکه آنها از یکی از روشهای ۱ و ۲ که خدمتتون عرض کردم دارن استفاده میکنن. من پیشنهاد میکنم سایت خودتون رو به این شکل با دیگر سایتها مقایسه نکنید، شاید همین که دیگر سایتها یه کاری که لازمه انجام بشه رو انجام نداده باشن خودش ایراد آن سایتها باشه و شما نباید صرفا به این دلیل اینکه آنها این کار و نکردن از انجام کار درست خودداری کنید.)